演者:甘利俊一先生 (理研)

題目:数理脳科学を夢見て半世紀

日時:2019年10月8日(火)15:00 - 18:00

場所:京都大学医学研究科・医学部記念講堂

概要:数理脳科学を夢見て半世紀以上が経った。その哲学と、いまだ熟していない成果とを振り返りたい。統計神経力学とランダム回路、連想記憶、学習と自己組織、スパイク解析と情報幾何などである。一方でAIが大流行である。AIと脳との関係を考え、さらにこれからの私の研究である深層ランダム神経場の構想を語りたい。

サロン・ド・脳 第5回は甘利俊一先生にご講演頂くことになりました.

100名を超す登録があり,当初の教室では収容不可に! 急遽,医学部の講堂に場所を移しての講演となりました.

「数理脳科学を夢見て半世紀」.甘利先生の軌跡が3時間たっぷり聞けるとあってみんな興味津々.

はじめは自己紹介,そして数理工学への道

数理工学は,近藤一夫先生(東京大学)が戦後の航空工学の研究禁止をうけて応用数学を始めたのに始まるというお話.5年後,航空工学が復活した時に数理の方が面白いと数理工学を立ち上げ.「学生は定員5名だけど,応募者はほとんどいない.自分の点数を見たら、いけるとこがここしかなかった(笑)」.

ドクターの後に学習とパターン認識を始めるのが1970年代.この10年は神経回路ひとすじ.「やりだすと、やさしいんですよね(笑)」.なんでもSebastian Seungに「あの時代はなにをやっても新しくて良かった」と羨ましがられたとか.しかし「やさしいものでも残るものは残る」.

それから新しいことをと,情報幾何・ICAに取り組み,最近はランダム深層神経場に興味があるとのこと.

天空の科学

数理脳科学はなにを目指すのか? 脳を材料に数理で遊ぶ.「それだけだと給料もらうのに調子が悪い(笑)」.こう考える:

情報に関わる基本的な原理があって,それが脳に発現してうまくいっていると考える.どう実現したかというと,進化によるランダムサーチ.これは古いのを捨てられない.脳の設計思想はごたごた.「だから脳を見て原理を調べるというのは、はかない夢ですよ」「天空にいけばわかる」(この挑戦的なお言葉に一同仰天と爆笑).

パーセプトロン

さて,講演は研究の中身の話へ.ローゼンブラットが出したパーセプトロンというのがある.0・1のMcCulloch-Pitts ニューロンを使う.マルチレイヤーのパーセプトロンの中間層の学習は難しい.「アナログニューロンならできる」:これが世界に先駆けたAmari 1967のオンライン確率勾配降下学習.アナログにして微分可能にするというアイデアは誤差逆伝播法に先駆けたアイデア(注:約15年ほど先をいっている).最近は深層学習が発展して,汎化誤差・計算量・局所解の発展がすさまじく、arXivに論文がどんどんでる.「最近の人は数学ができますねえ.難しく書くのが好きなんだよね(笑)」.

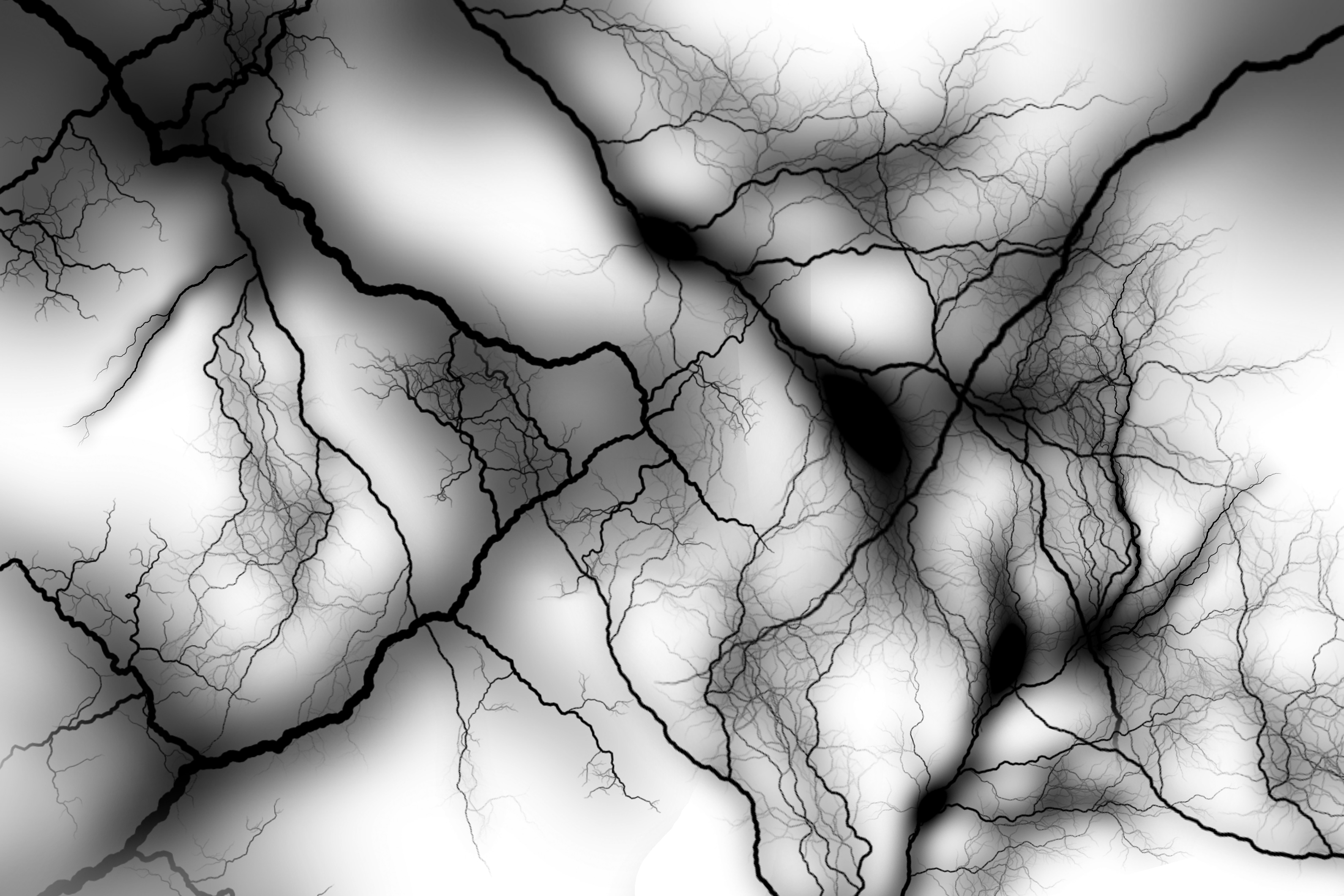

統計神経力学・神経場の力学

次に,ミクロのダイナミクスからマクロの神経ダイナミクスを導く統計神経力学の紹介.巨視的状態の安定性から振動回路へ.「今のWilson-Cowanモデル(1972)と呼ばれているのは,よく見ると1971のAmariモデルである」.そして連想記憶の話へ.「記憶容量の話は物理のSompolinsky, Amitらがレプリカ法というわけのわからないのを引っさげて解いているが,ダイナミクスはやっていない」.記憶想起のダイナミクスはどうなっているのか?これを馬被さんと行なった.途中まで想起できそうでいてやっぱりやめた,と想起に失敗する変わったダイナミクス.「実は収束のアトラクタはフラクタル構造になっているのではないか?」.

それからやったのが神経場の力学(Amari 1978).1次元の神経場の力学は偏微積分方程式.解けっこないからシミュレーションでやるのもいいが,「数理脳科学と言った以上,そこで放っておくわけにはいかない」.でも解けないものはとけない.ではどうするか.「解けなくても答えがわかればよい」(おおー).それで神経場の波形が安定であるための条件を解析.この話は始めの10年は引用がまったくなかったが1976年に突如復活して,今では引用数1000を超える.

神経学習

休憩を挟んで,後半は神経学習の話から.さまざまな学習則を統一的に扱う方法からスタート(Amari 1978),このひとつprinciple component analyzerは大した話ではないと思ったがOja(1980)が出してOjaのPCAとして知られる.甘利先生にすれば一般論のひとつ.

教師信号のない自己組織化学習の話へ.Hebb学習は発散してうまくいかないので抑制を入れる.このときの受容野の形成の話をされる.これに遅れてBCM理論が出た.これは抑制性は使わないで可変閾値をいれることで発散を防ぐが,同じ仕組み.ヘブ学習に如何に抑制をいれるかという違いに過ぎない.

そのころ来年の国際会議でこの話を発表してほしいとの話がくる.同じものを出すわけにはいかないということで作った自己組織神経場の理論の話へ.自己組織神経場に学習を入れる.これは解けないが,「執念で解くのが数理工学」.そこで平衡状態で変分法で安定解をだす.修士の学生がシミュレーションをするとこの解がでない.甘利先生の答えは間違っているという.甘利先生「それはでかしたこれでお前の修士論文ができる」.学生(竹内さん)がこの安定性解析をした(Takeuchi&Amari 1979).これはコラム構造が自動的にできる仕掛けを内臓していて,コホーネンの自己組織化マップでも本質的に同じことが言える(倉田).

情報幾何

「これ6時までだよね,もう5時半だ」.少し駆け足でのお話し.

これまでの話は10年やったが,神経回路モデルもそろそろ飽きてきた.解析できるものしか取り上げない.こういうのは職人の仕事.もっと面白いものはないか,ということで始めたのが情報幾何.3次相関は一意に定義できないと統計学者が言うので,「そんなばかなことはない」と高次相関を導入.2次の場合はよく知られていたが,直交性に基づくものとは誰も言わなかった.そして一般論として書いたのがAmari IEEE 2001.

高次相関の実験データの解析として島崎の時系列解析と同時不活性を紹介.「難しいんだ彼の理論は(笑).ところがその彼が突然わかりやすいことを始めた.同時不活性で高次相関が説明できる.これは私,仰天しました」(ありがとうございます[島崎]).その後,篠本さんの局所変動Lvの話.「篠本がLvとかいう変なのを思いつきでだした,思いつきを理論で裏付けなければならない.理論で篠本が正しいとなればよい,悪いとなればもっとよい(笑)」ということで,三浦さんとの仕事,発火率に直行する発火特性のセミパラメトリック統計推論の話.結果的に「篠本さんと非常に似ているものがでてきた」.

深層神経回路網

最後は駆け足で最近の深層学習の話.Hintonの2006年からリバイバルし「今や500層まである,どうしてそんなに必要がある? 腕力でやっているだけ.そんなことで世の中おさまりませんよ」.学習の理論的課題を解決したい.その課題として3つを挙げられる.一つ目は,過学習の問題.パラメータが多すぎると汎化誤差は大きくなるが,今のニューラルネットワークはものすごいパラメータ数があるが本当にいいのか? 二つ目は局所解と大域解の話.3つ目は計算の効率化.それぞれに対して,2重降下の話(Belkin 2019, Hastie 2019),ほとんどの局所解が大域解であるというKawaguchi 2019の理論,そして神経回路網をカーネル法で表すneural tangent kernelなど最新の話題を紹介.最後はNeural Tangent Kernelのランダム神経回路網への適用の話で終了.

甘利先生の壮大な軌跡が聞けただけでなく,2019年の理論の紹介まであり,一同驚嘆.質問も多彩なものが出ました.

甘利先生は当日に帰られるにもかかわらず,懇親会にも出席してくださいました.今回は寺前さんが懇親会担当.若い方,学生さんも多数参加してもりあがりました.

文責:島崎秀昭